목표

슬론 디지털 천체 관측 데이터를 가지고 천체의 타입을 분류해내는 것을 목표로 한다.

이를 위해서 train data로 학습을 하고 test data로 확인을 하는 과정을 거친다.

EDA (Exploratory Data Analysis : 탐색적 데이터 분석)

수집한 데이터를 다양한 각도에서 관찰하고 이해하는 과정이다.

# 필요한 패키지 import

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

from sklearn.model_selection import cross_val_score, train_test_split

from sklearn.neighbors import KNeighborsClassifier

from sklearn.preprocessing import StandardScaler

from sklearn.metrics import accuracy_score

import seaborn as sns

# 데이터 로드

train_data = pd.read_csv("train.csv")

train_data.shape

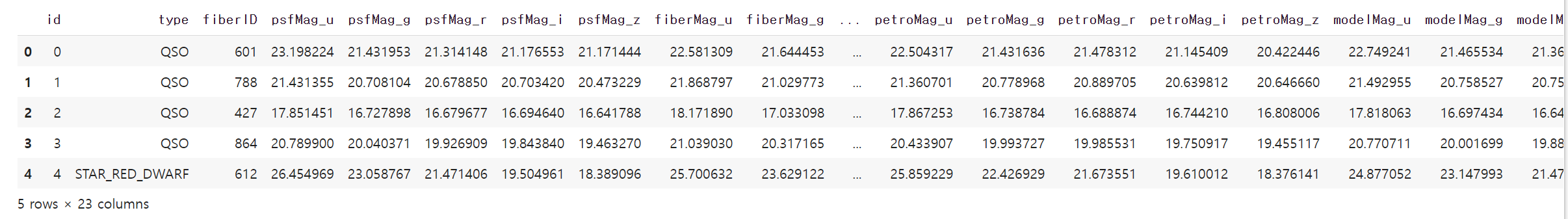

train_data.head()

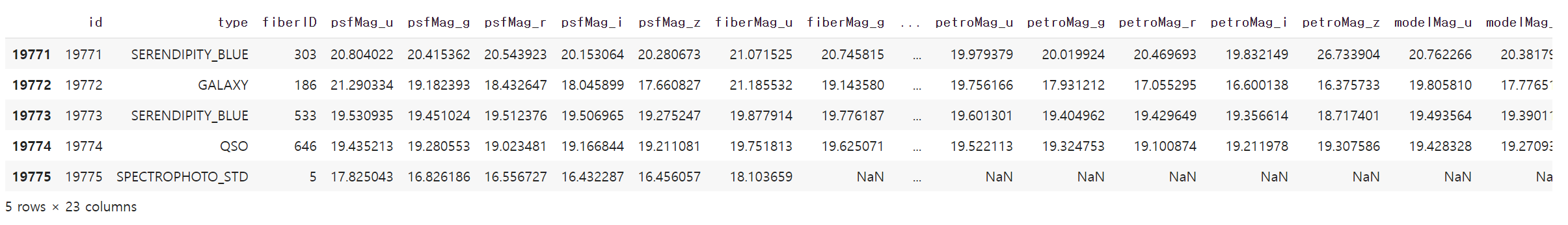

train_data.tail()

train_data.info()

train_data.isnull().sum()

fiberMag_g 부터 modelMag_z까지 null 값이 하나씩 존재한다.

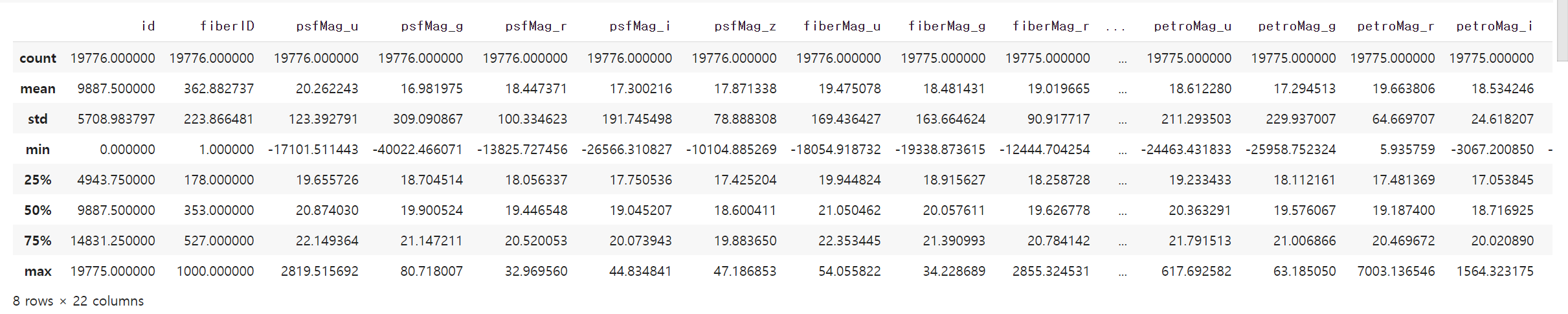

train_data.describe()

train_data.median()

id와 fiberID를 제외한 컬럼에서의 중앙값이 서로 비슷하다는 것을 알 수 있다.

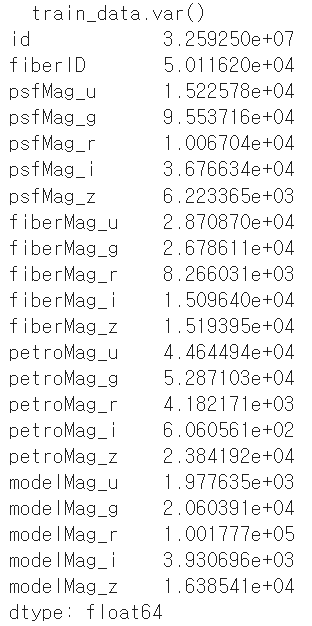

train_data.var()

psfMag_g와 fiberMag_r의 분산이 큰 것을 확인할 수 있다.

train_data['type'].unique()

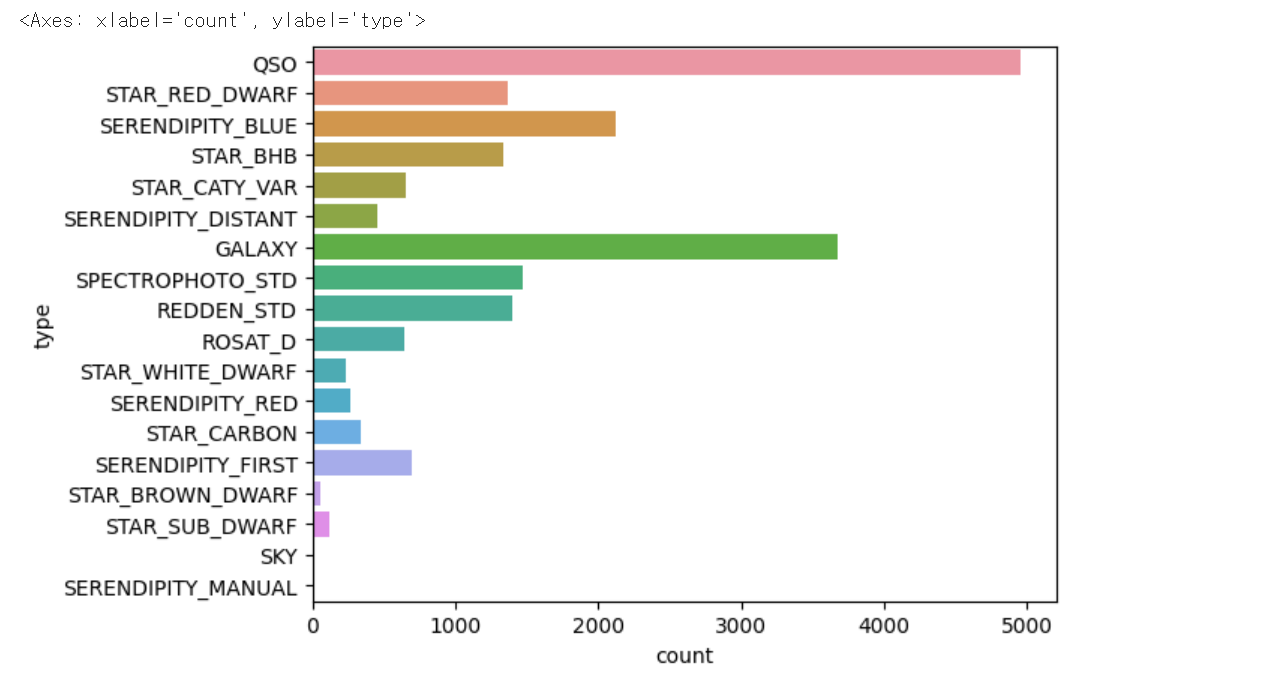

train_data['type'].value_counts()

QSO의 종류가 가장 많고 SERENDIPITY_MANUAL의 종류가 가장 적은 것을 알 수 있다.

sns.countplot(y='type', data=train_data)

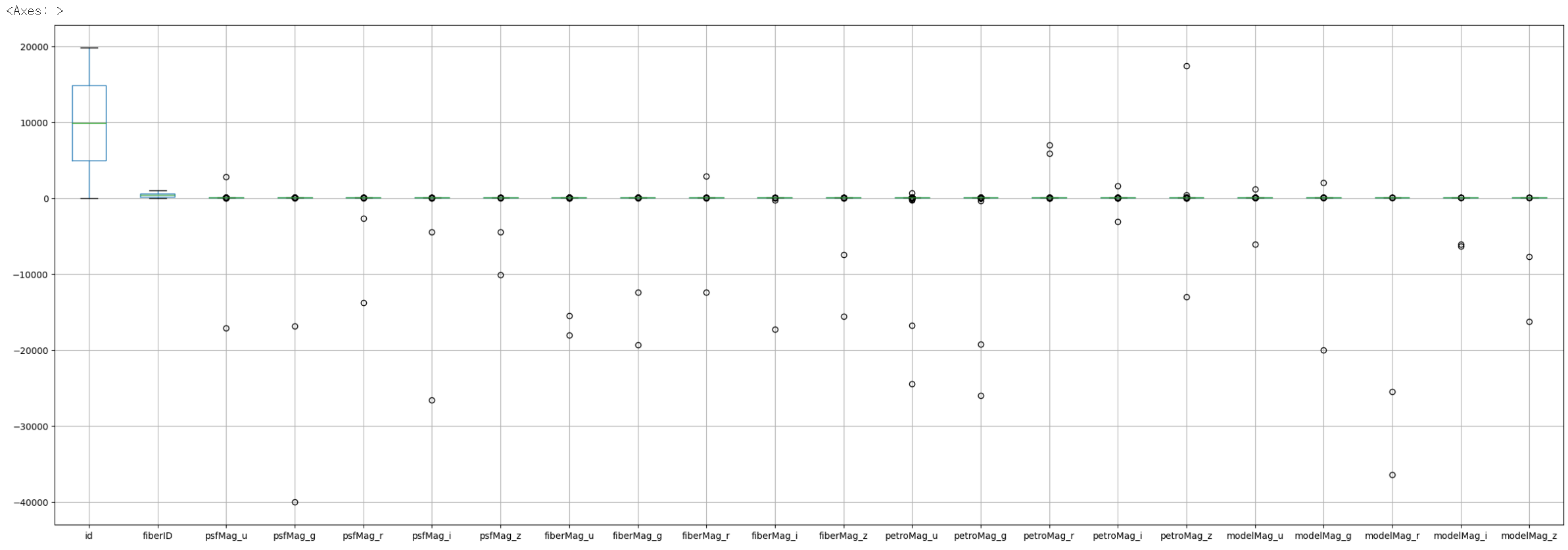

# 이상치 확인

train_data.boxplot(figsize=(30,10))

이상치가 많지는 않지만 존재하는 것을 확인할 수 있다.

→ 이상치를 어떻게 처리할 것인가에 대해 고민해보아야 한다.

모델링

[ KNN 알고리즘 ]

천체 데이터를 분석하기 위해서 KNN 알고리즘을 사용했다.

K-Nearest Neighbors(KNN) 알고리즘은 지도학습(Supervised Learning)의 일종으로, 분류(Classification)와 회귀(Regression) 문제에 모두 사용될 수 있는 알고리즘이다. 데이터 점들 간의 거리를 측정하여 가장 가까운 이웃들을 찾아내는 알고리즘을 말한다. 이렇게 찾아낸 이웃들의 레이블을 분류 문제(Classification)에서는 다수결 투표를 통해, 회귀 문제(Regression)에서는 이웃들의 평균값을 계산하여 예측한다.

KNN 알고리즘은 간단하면서도 분류 문제에서 높은 정확도를 보이는 알고리즘 중 하나이다. 그러나 데이터 포인트 간의 거리를 계산하기 때문에 데이터의 차원이 늘어날수록 계산 비용이 증가하며, 이상치(Outlier)에 민감해진다는 단점이 있다.

KNN은 모델을 학습시키는 과정이 없기 때문에, 실시간으로 데이터를 분류하거나 예측하는 데에 적합하다.

[ KNN의 하이퍼파라미터 분석 ]

하이퍼 파라미터란 머신러닝에서 어떠한 임의의 모델을 학습시킬 때, 사람이 직접 설정해야하는 변수를 말한다. 모델을 최적화하기 위해 하이퍼 파라미터 튜닝을 진행해야 한다.

1. KNN에서 제일 중요한 파라미터는 K이다. K는 이웃의 수를 말하는데 이를 어떻게 설정하느냐에 따라 결과가 달라진다.

- K값이 작을수록, 경계선이 민감해지며 더 정확한 예측을 할 수 있다. 특히 데이터가 잘 구분되지 않는 경우에 유용하다. 반면, train 데이터에 과도하게 맞추어져 새로운 데이터에 대한 일반화(generalization)가 저하되는 과적합(overfitting)이 발생할 가능성이 높다. 또한, 이상치(outlier) 데이터의 영향을 크게 받을 수 있다.

- K값이 클수록, 모델의 복잡도가 낮아져 더 일반화된 모델을 얻을 수 있으며 이상치 데이터의 영향을 줄일 수 있다. 반면, 작은 군집(cluster)을 분류하는데 어려움이 있을 수 있으며 과소적합 (underfitting)이 발생할 가능성이 높다.

- 따라서 적절한 K값을 찾을 때에는 교차 검증(Cross-validation)을 사용하여 최적의 K 값을 찾는 것이 좋다.

2. 다음 파라미터는 거리(Distance)이다. 거리 파라미터는 데이터 포인트 간의 거리를 측정하는 방법을 정의하는 파라미터이다. 주로 유클리드 거리(Euclidean distance)와 맨하탄 거리(Manhattan distance)를 사용한다.

- 유클리디안 거리는 일반적으로 가장 많이 사용하는 거리로, n차원에서의 두 점 사이의 거리를 통해 계산한다. 흔히 피타고라스 정리라고 불리는 것이다. 두 점 사이의 거리를 정확하게 계산하지만, 차원이 높아지거나 이상치(outlier)가 존재할 경우 거리 측정이 왜곡될 수 있다.

- 맨허튼 거리는 두 점 사이의 가로축과 세로축으로 이루어진 거리로 제한된 조건 하에서 정해진 루트를 통해 도달할 수 있는 거리를 말한다. 유클리디언 거리보다 계산 비용이 낮고, 특히 차원이 매우 큰 경우에 더 효율적이다. 또한, 유클리디언 거리보다 이상치(Outlier)에 덜 민감하다.

- 일반적으로는 차원이 크거나 이상치가 많은 경우에는 맨하튼 거리가 적합하고, 차원이 작고 이상치가 적은 경우에는 유클리디언 거리가 적합하다. 이 외에도 표준화 거리, 마할라노비스 거리, 체비셰프 거리, 민콥스키 거리, 캔버라 거리 등 다양한 거리가 존재한다.

[ 하이퍼파라미터 튜닝 ]

KNN 알고리즘에서는 파라미터를 조정하여 모델의 성능을 개선할 수 있다. 최적의 파라미터를 찾기 위해 그리드 탐색(Grid Search)이나 랜덤 탐색(Random Search)과 같은 하이퍼파라미터 튜닝 기법을 사용한다.

그리드 탐색은 가능한 모든 하이퍼파라미터 조합을 만들어서 조합들을 시도해보는 방법이다. 예를 들어, KNN 알고리즘에서 k 값이 1, 3, 5, 7이고, 거리 측정 방법이 유클리디안 거리와 맨하탄 거리 두 가지가 있다면, 모든 경우의 수를 다 해보면서 최적의 조합을 찾는 방법이다. 이 방법은 가능한 모든 조합을 다 시도하기 때문에 높은 정확도를 보장하지만, 계산 비용이 매우 높아질 수 있다.

반면에, 랜덤 탐색은 주어진 하이퍼파라미터 값의 범위 내에서 랜덤으로 조합을 선택해서 모델을 학습하고, 성능 지표를 평가하는 방법이다. 예를 들어, KNN 알고리즘에서 k 값이 1에서 10 사이의 정수 중 랜덤하게 선택되고, 거리 측정 방법도 랜덤하게 선택되는 경우이다. 이 방법은 그리드 탐색에 비해 더 빠르게 하이퍼파라미터 공간을 탐색할 수 있다. 그러나 랜덤 탐색은 최적의 하이퍼파라미터 값을 찾지 못할 가능성이 있다.

따라서, 하이퍼파라미터 공간이 매우 큰 경우 랜덤 탐색을 사용할 수 있고, 그렇지 않은 경우에는 그리드 탐색을 사용하는 것이 좋다.

[ KNN 알고리즘 구현하기 ]

null 값이 존재하면 모델링 과정에서 오류가 발생한다. 따라서 null 값을 채워주어야 한다. 그런데 아직 어떠한 방법으로 null 값을 채우는 것이 가장 좋은 방법인지 찾지 못하여 일단은 null 값을 삭제한 상태로 모델링을 진행해보았다.

# null 값이 존재하면 모델링 과정에서 오류 발생

train_data = train_data.dropna()

# type과 나머지 데이터들을 분리해줌

X = train_data.iloc[:, 2:]

y = train_data.iloc[:, 1]

# 데이터셋 분할 (학습용 데이터와 검증용 데이터)

# training과 test의 비율은 0.3

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

train_test_split()은 기본적으로 훈련데이터 세트를 75:25의 비율로 나눈다. 이 비율을 test_size 매개변수에 테스트 세트의 비율을 전달하여 조절할 수 있다. 데이터 세트의 30%를 테스트 세트로 나누기 위해 0.3을 전달했다.

train_test_split()는 데이터를 무작위로 섞은 뒤, 데이터 셋을 나누기 때문에 함수를 호출할 때마다 다른 결과로 분할이 된다. 이때 random_state를 특정 숫자로 지정하면 항상 동일하게 분할할 수 있다. 실제 상황에서는 거의 필요 없지만, 다른 사람들과 결과를 공유하거나 실험 결과를 똑같이 재현해야 할 때는 유용하게 사용한다.

[ 최적의 K값 찾기 ]

# 최적의 k값 찾기

k_values = []

accuracy_values = []

for k in range(1, 11):

knn = KNeighborsClassifier(n_neighbors=k)

knn.fit(X_train, y_train)

score = knn.score(X_test, y_test)

k_values.append(k)

accuracy_values.append(score)

n_neighbors는 가장 가까운 이웃을 몇 개 고를지에 대한 파라미터이다.

# KNN 시각화

plt.plot(k_values, accuracy_values, 'o-') # 데이터 포인트에 점(o)과 선(-)이 함께 표시

plt.xlabel('k')

plt.ylabel('Accuracy')

plt.title('Accuracy for Different Values of k')

plt.xticks(k_values) # 눈금 설정

plt.show()

시각화를 통해 k가 5일 때 정확도가 가장 높다는 것을 확인할 수 있다. 그러므로 최적의 k 값은 5가 된다.

# 최적의 k 값을 이용하여 모델 생성, 학습, 검증

best_k = 5

model = KNeighborsClassifier(n_neighbors=best_k)

model.fit(X_train, y_train)

y_pred = model.predict(X_test)

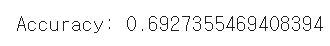

accuracy = accuracy_score(y_test, y_pred)

print("Accuracy:", accuracy)

데이터에서 이상치를 어떻게 처리할 것인가, null 값을 어떠한 방법으로 채워야 하는가, 어떤 거리를 이용해야 할까에 대한 고민을 통해 현재의 정확도보다 더 높은 확률이 나오도록 해야한다.

'💡 WIDA > DACON 분류-회귀' 카테고리의 다른 글

| [DACON/김민혜] 천체 분류 경진대회 (5) | 2023.05.06 |

|---|---|

| [DACON/조아영] 천체 분류 경진대회 (4) | 2023.05.06 |

| [DACON/김경은] 프로젝트 에세이 (4) | 2023.05.05 |

| [DACON/김세연] 프로젝트 에세이 (4) | 2023.05.05 |

| [DACON/김규리] 프로젝트 에세이 (4) | 2023.05.05 |